Fréquemment, si ce n’est régulièrement, depuis quelques années, on reparle du travail de Ned Nikolov et Karl Zeller, deux scientifiques américains qui critiquent l’effet de serre, tel qu’il est communément admis dans la communauté des croyants du GIEC. Un effet de serre qui voudrait que certains gaz, éventuellement rares, soient responsables à eux seuls de la température à la surface de la Terre. Un effet de serre, qui expliquerait aussi la température à la surface de la planète Vénus, agitée comme un épouvantail, l’image de ce qui attendrait la Terre si l’on n’entendait pas enfin raison. Selon leurs recherches, il n’y aurait pas d’effet de serre proprement dit, de toute façon fort mal nommé, mais un effet d’atmosphère ne devant rien à sa composition. Ces deux scientifiques n’auraient besoin que de connaître la distance au Soleil et la pression atmosphérique au sol pour connaître la température moyenne de surface d’une planète tellurique. Or, si la composition de l’atmosphère ne compte pour rien dans cette affaire, cela signifie qu’elle peut varier sans conséquence sur l’équilibre thermique de l’astre. Accepter leurs conclusions, c’est voir tout l’échafaudage du GIEC s’effondrer.

D’un point de vue réchauffiste, on s’étonnera que les vilains climatosceptiques stipendiés ne se soient pas jetés comme un seul homme sur ces travaux, afin de les brandir comme une preuve irréfutable de l’innocence du dioxyde de carbone. Ces recherches ont été discutées par eux et le sont encore, puisqu’elles reviennent de temps à autre sur le devant de la scène, surtout médiatique.

L’article de Nikolov et Zeller datant de 2017 est consultable ICI. On en trouvera de plus anciens sur la toile.

Leur théorie a fait parler d’elle récemment en français grâce à un article traduit, paru sur le site La Terre du futur.

Le physicien de l’atmosphère Roy Spencer en a récemment parlé sur son blog, en reprenant un ancien argument de Willis Eschenbach. Ned Nikolov lui a répondu. Comme il avait déjà répondu, avec son collègue Karl Zeller, à un article critique de Willis Eschenbach en 2012.

Les lecteurs curieux, lisant l’anglais et suffisamment versés dans la physique pourront s’en donner à coeur joie, car la discussion se poursuit longuement dans les commentaires.

Le propos de cet article n’est pas de commenter ces échanges, encore moins de trancher, mais de prendre en compte le fait que nombre de lecteurs de l’article paru dans La Terre du futur ne sont guère au courant du contexte et pensent que pour la première fois une alternative est donnée à la théorie de l’effet de serre. Or, cette dernière a une histoire, qu’il n’est pas superflu de connaître quand on s’intéresse à l’évolution récente du climat et à ce qu’en disent les scientifiques, les politiques et les médias. Raison pour laquelle sont donnés ici à lire de très longs extraits de Climat, mensonges et propagande, paru fin 2010. Où il est question de l’histoire de l’influence que l’Homme a pensé avoir sur le climat, sur la naissance de la théorie de l’effet de serre et sur quelques critiques qui peuvent en être faites.

[Pour le confort de la lecture, les nombreuses références bibliographiques ne sont pas reportées]

Chapitre 1 – Un peu d’histoire

Loin des moyennes, des cartes de pression atmosphérique, des roses des vents, le climat, aussi abstrait soit-il, est cerné par l’individu, qui, pour peu qu’il soit observateur, sait généralement assez bien si le temps qu’il fait est habituel ou s’il s’écarte singulièrement de la variabilité naturelle. Pas besoin de faire appel à un spécialiste pour repérer un été caniculaire ou pourri, un hiver particulièrement doux ou très rigoureux. Chacun, aujourd’hui comme hier, effectue donc, inconsciemment et avec moins de précision (faut-il le préciser ?) la synthèse que le climatologue est en charge de mener. Mais la notion de climat, elle, est difficile à définir et a sensiblement différé au cours de l’histoire. Le terme « climat » vient étymologiquement du latin clima, lui-même emprunté au grec, qui signifie inclinaison. Il désignait à l’époque antique l’angle que font les rayons du Soleil avec la surface terrestre, inclinaison qui dépend de la latitude. Les différents climats de la Terre pour l’Antiquité grecque et romaine étaient donc des bandes parallèles à l’équateur et dépendaient de l’éloignement à celui-ci.

LA TYRANNIE DU CLIMAT

La propension à intégrer la succession des types de temps, à en faire une synthèse inconsciente permettant de savoir si l’on est dans la norme ou dans l’excès, voire à saisir une éventuelle évolution climatique, étant une faculté universelle, l’Homme de l’Antiquité en était capable, comme chacun d’entre nous. Ainsi, Théophraste, philosophe grec du IVe siècle avant J.-C., qui a beaucoup écrit sur le milieu naturel et particulièrement sur le règne végétal, a émis l’hypothèse que les déforestations entraînaient invariablement un phénomène d’assèchement par baisse des précipitations. Il y avait là les bases d’une approche de l’action de l’Homme sur le climat, action dont l’importance aurait pu être appréhendée. Les exemples de Théophraste restaient de dimension locale, mais cette théorie permettait d’envisager, sous condition de vastes déboisements, des conséquences climatiques pouvant atteindre des dimensions spatiales plus importantes, au moins régionales. Néanmoins, ce point de vue n’a pas trouvé écho chez ses contemporains, ni sous l’empire romain. Pline l’Ancien (23-79 après J.-C.), dans son Histoire Naturelle, constate également une évolution locale du climat suite à des pratiques culturales, mais il considère cependant que le climat est éminemment stable. Pour lui, c’est une constante du milieu naturel qui, malgré quelques constatations locales et secondaires, ne saurait évoluer. L’Homme ne peut avoir de réelle action sur le climat. C’est une relation totalement dissymétrique, car pour les savants de l’époque le climat définit le caractère des peuples. Ainsi, la civilisation gréco-romaine étant pour ses représentants, largement supérieure à toutes les autres, le climat qui l’a façonnée ne pouvait être que le plus favorable. Et celui sous lequel vivaient les barbares, à la limite du vivable. Que l’on s’éloigne un tant soit peu de l’empire romain et la péjoration climatique devient catastrophique. Très vite, en s’éloignant de la douceur méditerranéenne, on arrive aux limites de la zone habitable. Aux marches même de l’empire romain, Ovide, au tout début de notre ère, exilé sur les bords de la mer Noire dans une ancienne colonie grecque, décrit des tribus frustes, vivant dans un climat terrible. La peinture qu’il dresse de ce qui est aujourd’hui pour les classes moyennes et riches de Russie et d’Ukraine un lieu de villégiature estivale, est digne du grand nord, avec des neiges persistant au sol tout l’été, le Danube et la mer gelant tous les hivers. Même en imaginant un climat légèrement plus froid que de nos jours, il est manifeste qu’il y a exagération. Il est inenvisageable que la neige n’ait pas fondu dès le retour du printemps. La volonté d’apitoyer Rome pour mettre fin à son exil, de même que des propos emphatiques au service de son œuvre littéraire peuvent expliquer en partie cette exagération. Mais cette vision des marches de l’empire est aussi conforme à la représentation intellectuelle que l’on se faisait à l’époque des régions septentrionales bordant le limes, règne du froid implacable. De la même manière, les confins méridionaux sont la proie d’une chaleur infernale. Un siècle avant, Pline, Diodore de Sicile, qui décrit de manière similaire les régions au nord, n’est pas en reste avec le sud. Selon lui, aux confins de l’Égypte, la chaleur est telle que l’on ne distingue rien en plein midi, l’évaporation rapide réduisant considérablement la visibilité. L’évaporation de l’eau du corps est d’ailleurs tellement importante que si la soif n’est pas étanchée sur-le- champ, la mort survient en peu de temps. Et que l’on ne se risque pas à poser un pied nu sur le sol, sous peine de brûlure immédiate. Bref, dans le monde gréco-romain, la normalité climatique est de rigueur : tout éloignement vers le nord ou le sud expose à des conditions climatiques se dégradant à une vitesse inouïe, si bien que les régions en question ne sont rapidement plus habitables. La zone torride ne peut être qu’inhabitée. Au nord des steppes ukrainiennes ou de l’Angleterre, plus âme qui vive. Et, bien avant, les Hommes obligés de vivre comme des bêtes.

Une telle conception de la tyrannie du climat, facteur explicatif du caractère des peuples, va perdurer jusqu’au XVIIIe siècle. On la retrouve par exemple dans l’article Climat, écrit par d’Alembert dans l’Encyclopédie. Cette idée sera celle de presque toutes les Lumières, au premier rang desquelles Montesquieu, mais à l’exception notable de Voltaire. On a certes progressé depuis l’Antiquité dans la connaissance géographique de la Terre, les régions habitables sont plus vastes qu’on ne le croyait. Mais la conception zonale du système climatique mondial demeure, de même que le caractère univoque de la relation entre les Hommes et le climat. Les Hommes sont totalement inféodés aux conditions climatiques, au point d’être déterminés jusque dans leur couleur de peau. D’Ibn Khaldoun, historien arabe de la seconde moitié du XIVe siècle, à l’Abbé Dubos du siècle des Lumières, on croit qu’en changeant de latitude les Blancs peuvent devenir noirs et les Noirs devenir blancs. Dubos estime que cette transformation prend quelques siècles. Qu’une information erronée parvienne alors au savant, comme l’existence d’une importante population blanche au centre de l’Afrique, dont l’intérieur reste mystérieux, et l’on adapte la réalité qu’on ignore pour expliquer la théorie : le grand naturaliste Buffon fait de l’Afrique centrale le siège de hautes terres au climat compatible avec le teint clair des Hommes qui étaient supposés l’habiter.

Les caractéristiques physiques ne sont pas les seules affectées. Les Lumières pensent que les peuples du nord, âpres au travail, courageux, deviendraient, sous des latitudes plus chaudes, apathiques et médiocres. Le racisme envers les autres peuples et particulièrement le continent africain est manifeste, mais, à la décharge des philosophes de l’époque, ils ne font pas de ces défauts des éléments intrinsèques aux Hommes : résultats de la fatalité climatique, ils peuvent évoluer en changeant simplement de climat.

PROGRÈS SOCIO-ÉCONOMIQUE ET PROGRÈS CLIMATIQUE

Durant le XVIIIe siècle, l’idée d’une action possible et positive de l’Homme sur le climat s’impose comme un changement de paradigme : l’Homme peut désormais devenir le maître du jeu, l’âge de la Raison triomphante doit permettre à celle-ci d’agir non seulement sur la société, mais également sur le milieu naturel. L’idée moderne de Progrès s’impose. Dans la deuxième moitié du XVIIIe siècle, Edward Gibbon, auteur d’une Histoire de la décadence et de la chute de l’Empire romain, considère qu’il y a suffisamment d’indices pour admettre que le climat d’Europe était plus froid à cette époque. Il justifie ainsi cette différence : « Les travaux des Hommes expliquent suffisamment les causes de la diminution du froid. Ces bois immenses qui dérobaient la terre aux rayons du Soleil, ont été détruits. À mesure que l’on a cultivé les terres et desséché les marais, la température du climat est devenue plus douce. Le Canada nous présente maintenant une peinture exacte de l’ancienne Germanie ». L’influence du climat étant majeure sur les civilisations, c’est lui qui explique la supposée vigueur des Germains, qui ont ainsi pu vaincre Rome. Depuis, les défrichements ont amélioré le climat, qui a lui-même eu une influence favorable sur les peuples, permettant l’instauration d’un cercle vertueux. Le progrès social et économique implique le progrès climatique qui le favorise à son tour. Thomas Jefferson, troisième président des États-Unis, considérant lui aussi que le recul de la végétation était responsable de la douceur relative de l’Europe par rapport à la rigueur du temps hivernal nord-américain, souhaitait la même chose pour son pays. Un tel optimisme va partiellement perdurer au XIXe siècle : pour Charles Fourier (et non pas Joseph, que l’on rencontrera plus tard), la mise en culture de la totalité du globe conduirait à adoucir les climats de la Terre dans des proportions qui feraient pâlir nombre d’experts actuels : en Sibérie et au Canada, où l’amélioration pourrait atteindre 12 °C, mais aussi en Europe, où le philosophe attendait 6 °C de plus. Il faut dire que cette époque, dite du Petit âge glaciaire (finissant), n’était pas avare en hivers très rudes.

DE LA THÉORIE DE L’ASSÈCHEMENT À L’EFFET DE SERRE

Cette vision positive de l’action de l’Homme sur le climat par le biais de la déforestation n’est cependant pas la seule au siècle des Lumières, même si c’est celle qui domine largement. Émerge en effet peu à peu, dès la Renaissance, au sein des colonies du sud au climat tropical, une autre perception des choses. À partir de cette période s’affirme la redécouverte des écrits antiques. Les œuvres de Théophraste sont traduites et diffusées et mettent en garde les planteurs des nouvelles colonies portugaises et espagnoles, comme Madère et les Canaries, contre une possible catastrophe économique. Et de fait, dans ces colonies, il y eut concomitance entre déforestation et baisse des précipitations. En ayant eu connaissance, Christophe Colomb aurait redouté qu’un tel scénario ne se reproduise dans les Indes occidentales. Cette crainte subsistera, surtout dans les colonies concernées par les climats tropicaux. La théorie de l’assèchement, de la baisse des précipitations comme conséquence de la déforestation, contribuera fortement à la naissance de l’environnementalisme moderne, avant même que l’on se préoccupe de biodiversité.

La base contemporaine de cette théorie se trouve dans les travaux sur la transpiration des plantes, dont les fondements sont établis par John Woodward en 1699. Henri-Louis Duhamel du Monceau, botaniste et agronome français, publie en 1760 un ouvrage dans lequel il fait le lien entre arbres et climat. Ces idées seront diffusées à l’Académie des sciences et vont retraverser le Channel, où elles seront discutées à la Society of Arts anglaise, avec des académiciens français. Il n’est alors question que des colonies de latitude tropicale, les bienfaits de la déforestation n’étant pas remis en question pour l’Europe, qui en aurait largement bénéficié, et surtout l’Amérique du Nord, qui en attend beaucoup. Les observations de déforestations suivies de sécheresses dans les colonies ont été un moteur pour le mouvement de conservation de la nature. La signature du Traité de Paris (1763) mettant fin à la Guerre de Sept Ans a permis la mise en application de ces idées protectionnistes. De larges parts d’espaces montagneux d’îles des Caraïbes passées sous la loi britannique, et encore largement peuplées d’Indiens (on ne porte donc pas tort aux planteurs), deviennent ainsi des réserves forestières « pour la protection des pluies », les premières jamais créées pour prévenir un changement climatique. Des réserves similaires sont créées en 1769 sur l’île Maurice par Pierre Poivre, qui en était le commissaire-intendant, par ailleurs grand avocat de la protection des forêts coloniales. Les arguments avancés pour leur mise en place sont les mêmes que pour celle de l’Empire britannique : en 1763, Poivre fit à Lyon un discours dans lequel il lie déforestation et assèchement, qui peut être considéré comme le premier texte mettant en garde contre le changement climatique. En 1790-1791, un puissant « El Niño » eut lieu, avec comme conséquence d’importantes sécheresses dans le sud de l’Inde, à Sainte-Hélène, aux Antilles, en Amérique Centrale, en Australie. Ce fut un puissant accélérateur pour la protection attendue du climat, via celle des forêts.

Ce furent les administrations coloniales qui jouèrent le rôle principal dans la diffusion et la prise en compte de la théorie de l’assèchement ; l’influence des centres métropolitains fut relativement minime. Il y eut malgré tout un vaste mouvement de protection des forêts en Europe, surtout dans les pays ayant d’importants massifs montagneux, au premier rang desquels la France. Les références à d’éventuelles péjorations climatiques induites par le déboisement n’ont pas été l’élément décisif en l’occurrence, bien que certaines sociétés savantes départementales aient mentionné, notamment, une augmentation de la fréquence des fortes averses. En France, un ouvrage, publié en 1840 par l’ingénieur des Ponts et Chaussées Alexandre Surrel, Étude sur les torrents des hautes Alpes, va jouer un rôle majeur. Les déboisements y sont montrés du doigt et à travers eux les populations montagnardes jugées responsables des catastrophes s’abattant sur la nation. C’est à cette époque qu’est forgée l’expression « manteau forestier », en référence au pouvoir protecteur qu’on prête aux peuplements boisés. En déboisant inconsidérément, les populations montagnardes sont tenues responsables des crues catastrophiques touchant les plaines. La solution à ces maux vient de deux des grands corps d’État : les ingénieurs forestiers d’une part, qui reboisent vigoureusement au sein d’un vaste programme appelé Restauration des Terrains en Montagne (RTM), et, d’autre part, ceux des Ponts et Chaussées, grâce à des travaux hydrauliques. Cette manière de percevoir les choses est toujours d’actualité chez la majorité des ingénieurs, mais le monde de la recherche n’est pas aussi univoque, loin s’en faut. Voici ce qu’en dit l’historien du climat Emmanuel Garnier dans son dernier livre : « Largement orchestré par le lobby des ingénieurs des Ponts et Chaussées et des Eaux et Forêts, ce postulat fait aujourd’hui toujours l’objet d’un débat entre spécialistes. En contradiction formelle avec les grands corps de techniciens, l’historien suisse Christian Pfister est allé jusqu’à parler d’une “carrière publique du paradigme du déboisement” qui aurait effacé la dimension climatique ». Le climat n’a pas été invoqué en Europe dans un débat largement confisqué par le génie alors même qu’il eut été un excellent facteur explicatif, prépondérant à défaut d’être le seul. Inversement, dans les colonies, il est largement mis en avant pour justifier la protection des forêts tropicales, de manière parfois instrumentalisée par ceux ayant avant tout pour but, louable, la protection d’espaces et d’espèces jugés remarquables, sans réelle considération pour l’avenir climatique.

Les centres métropolitains vont cependant entrer dans le débat sur l’assèchement, mais aussi dans l’action. Ainsi, la création de la future administration forestière des Indes (là où auparavant n’existaient que des centres locaux) découle directement d’un rapport de 1851 pour l’Association britannique pour l’avancement des sciences (BAAS), dont le but était d’examiner les conséquences qu’aurait la destruction des forêts tropicales, notamment du point de vue des retombées économiques. Le débat va cependant prendre une autre tournure et dépasser la seule question de la déforestation. C’est encore au sein de la BAAS qu’est exposé en 1858, un article de Spotswood Wilson Sur l’assèchement progressif et général de la Terre et de l’atmosphère. Quelques années plus tard, en 1865, il en fait paraître un autre très semblable, qui est, lui, discuté à la Royal Geographical Society. La théorie de l’assèchement y est réaffirmée, particulièrement dans le deuxième article. Inspiré par les écrits de voyageurs décrivant des paysages desséchés d’Afrique, d’Australie, du Pérou, où partout l’Homme habite, Wilson explique que celui-ci est l’unique responsable. Mais il va plus loin et marque là un tournant important. Selon lui, déforestation et usage immodéré de l’eau ne peuvent suffire pour expliquer ce processus d’assèchement. Une modification des taux d’oxygène et de dioxyde de carbone en est aussi responsable. Avec cet article, peut-être le premier sur l’effet de serre anthropique, il initie un débat vraiment international sur l’environnement, en annonçant la fin de l’humanité causée par des changements dans l’atmosphère, dont elle est responsable. La théorie de l’effet de serre n’est pourtant alors que l’affaire de spécialistes, et demeure en pleine formulation.

UNE ANALOGIE QUI A FAIT FLORÈS

Les montagnes, comme on le verra plus particulièrement un peu plus tard, vont jouer un rôle d’importance dans les interrogations ayant mené à l’étude de l’effet de serre. Parmi les savants qui les ont beaucoup fréquentées, Horace-Bénédict de Saussure occupe une place à part, ne serait-ce que parce qu’il est considéré comme l’un des pères de l’alpinisme. Ce naturaliste et géologue genevois, infatigable arpenteur des Alpes, était un esprit curieux, qui n’hésitait pas à imaginer les instruments dont il avait besoin pour ses expériences. L’une d’elles est à l’origine des travaux sur l’effet de serre. Voulant comprendre pourquoi il fait plus froid au sommet des montagnes que dans les plaines environnantes, il invente l’ancêtre des capteurs solaires, qu’il nomme héliothermomètre, afin d’étudier les effets calorifiques des rayons du Soleil. La température est mesurée à l’intérieur d’une boîte composée de cinq caisses de verre emboîtées les unes dans les autres, avec un fond noir absorbant. Il a derrière la tête la volonté de montrer que le rayonnement solaire est aussi efficace en altitude qu’en plaine, malgré les plus faibles températures qui y règnent. Ce qui, implicitement, signifie que la différence de température n’est pas à chercher dans les effets directs du Soleil. L’expérience est menée en juillet 1774, en plaine et en montagne. L’élévation de température est identique dans les deux cas, malgré la différence d’altitude. Saussure explique ainsi les résultats de son expérience : sans les vitres de son dispositif, la mesure de température eut été biaisée, particulièrement en altitude, car la chaleur accumulée aurait été « en grande partie dérobée par les courants qui règnent dans l’air ». Le nombre de vitres a permis cette conservation de la chaleur et donc la comparaison entre plaine et montagne. C’est le confinement de l’air, non renouvelé, qui a empêché son remplacement par une atmosphère plus fraîche et qui est responsable du succès de l’expérience menée par Saussure. Comme une serre qui maintient l’air réchauffé à l’intérieur, où règne une température plus chaude ou douce qu’à l’extérieur, en empêchant simplement la convection : qu’une fenêtre de la serre soit ouverte et l’air chaud, moins dense que l’air plus frais de l’extérieur, s’élèverait dans l’atmosphère, tandis que l’air de cette dernière rentrerait et ferait baisser la température.

Cette expérience fondatrice de Saussure est commentée dans Remarques générales sur les températures du globe terrestre et des espaces planétaires, publiées en 1824 par le mathématicien et physicien français Joseph Fourier, qui peut s’appuyer sur les cinquante années de découvertes scientifiques qui le séparent de son prédécesseur, notamment celle de l’astronome anglais William Herschel, qui veut que tout corps rayonne, mais d’une « chaleur rayonnante », dite aussi « chaleur obscure », d’une manière différente de la lumière visible (blanche). Nous dirions maintenant que le rayonnement électromagnétique se décrit comme une onde, dont la longueur dépend de la température du corps qui l’émet. Le Soleil, dont la température de surface est de l’ordre de 6 000 °C, émet essentiellement dans des longueurs d’onde correspondant à la lumière visible, blanche, secondairement à des longueurs d’ondes plus faibles, les ultraviolets (UV), ou plus grandes, le proche infrarouge. La Terre, elle, à cause d’une température de surface beaucoup moins élevée, émet dans l’infrarouge moyen. Fourier reprendra l’explication de Saussure pour expliquer le mécanisme de son expérience : « La chaleur acquise se concentre, parce qu’elle n’est point dissipée immédiatement par le renouvellement de l’air ». Mais il va plus loin : selon lui, le verre n’est pas un obstacle au rayonnement solaire, il laisse passer les longueurs d’onde de la lumière visible. À l’intérieur de l’héliothermomètre, le fond noir qui s’échauffe va, lui, rayonner dans l’infrarouge, une longueur d’onde que le verre, nous dit Fourier, ne laisse pas passer. Le physicien français y voit plus qu’une analogie avec l’atmosphère terrestre : « (…) la température peut être augmentée par l’interposition de l’atmosphère, parce que la chaleur trouve moins d’obstacle pour pénétrer l’air, étant à l’état de lumière, qu’elle n’en trouve pour repasser dans l’air lorsqu’elle est convertie en chaleur obscure ». Fourier décrit là le principe général de ce que l’on nomme aujourd’hui effet de serre. Bien qu’impropre, puisque le verre ne bloque qu’assez peu le rayonnement infrarouge, la comparaison avec la serre sera tellement parlante que l’effet de serre sera ainsi nommé, en dépit d’une expérience de 1909 menée par Robert William Wood ayant montré que le verre d’une serre, opaque au rayonnement infrarouge, n’augmente quasiment pas plus la température du dispositif que s’il est remplacé par un matériau aussi transparent à cette longueur d’onde qu’à la lumière visible. Le confinement, empêchant toute convection de l’air et donc son renouvellement, explique à lui seul le comportement thermique d’une serre.

DE L’ÉTUDE DES GLACIATIONS AU DIOXYDE DE CARBONE

La contribution des montagnes à la découverte de l’effet de serre continue grâce à l’étude des glaciers. Durant le XIXe siècle, les montagnes suscitent un intérêt majeur aussi bien chez les artistes que chez les scientifiques. Ces derniers s’interrogent notamment sur les blocs erratiques, des blocs de roche dont la disposition échappe à toute explication rationnelle. « Les granites ne se forment pas dans la terre comme des truffes, et ne croissent pas comme des sapins sur les roches calcaires », écrit Saussure. De fait, bien souvent, ils ne peuvent être rattachés à la géologie locale. Par ailleurs ils se présentent parfois sous forme d’alignements de chaque côté d’une vallée alpine ou encore isolément, dans les plaines situées au pied des montagnes. Les explications imaginées pour justifier l’existence de ces blocs erratiques seront aussi variées qu’erronées. L’une d’entre elles fait même implicitement référence au Déluge en imaginant leur transport par des masses d’eau considérables. Bien avant tout le monde, c’est le scientifique écossais John Playfair qui aura la bonne intuition et expliquera l’existence des blocs erratiques par le mouvement des glaciers en 1802. Mais c’est l’ingénieur en chef du canton du Valais, Ignace Venetz, qui formula scientifiquement cette hypothèse. Dès 1821, dans son Mémoire sur les variations de température dans les Alpes, il explique que, par le passé, les glaciers ont connu des phases d’avancée et de recul. Lors des avancées ils ont poussé devant eux des débris de roches de taille très variable, laissés sur place lors des reculs. Sa thèse va à l’encontre de l’idée alors répandue que la Terre ne cesse de se refroidir depuis sa création, mais elle se répand peu à peu, jusqu’à ce que le savant suisse Louis Agassiz s’en empare et propose en 1837 l’existence de plusieurs âges glaciaires dans le passé de la Terre. Il l’expose dans son œuvre majeure en la matière Études sur les glaciers en 1840. Selon lui, non seulement les glaciers alpins se sont étendus jusque dans la vallée du Rhône, mais ils ont entièrement recouvert la Suisse. L’idée de fluctuations climatiques passées s’impose, mais leur explication reste à trouver. Deux thèses principales seront proposées : l’effet de serre d’une part, les variations de l’orbite terrestre de l’autre.

C’est en cherchant les causes possibles de ces périodes glaciaires que l’Irlandais John Tyndall a étudié les capacités d’absorption des gaz composant l’atmosphère. Il conclut en 1861 que cet effet de serre est dû principalement à la vapeur d’eau. Cette dernière et, plus secondairement, le dioxyde de carbone (on parle d’acide carbonique à l’époque) jouent un rôle important dans le climat de la Terre, si bien que des variations de leurs concentrations respectives peuvent expliquer ces changements climatiques : « Un léger changement dans les constituants variables de l’atmosphère suffit pour que se modifie la quantité de chaleur retenue à la surface de la Terre enveloppée par la couverture d’air atmosphérique ». Pour intéressante qu’elle soit, cette explication des vicissitudes climatiques du passé selon Tyndall achoppe sur un point important : quelle pourrait bien être l’origine de ces variations de concentration des gaz au sein de l’atmosphère ? On ne conçoit à l’époque qu’une origine possible : l’action humaine, ce qui ne peut être le cas pour ces époques reculées.

Bien qu’insatisfaisante, cette théorie des variations de concentration des gaz atmosphériques comme moteur des glaciations passées ne sombre pas dans l’oubli : elle est à nouveau utilisée par un brillant chercheur, Svante August Arrhenius, chimiste suédois qui reçut le prix Nobel de chimie pour un tout autre travail que celui qui nous intéresse ici. Les glaciations ont aussi retenu son attention et il cherche le mécanisme permettant d’expliquer les variations de température de l’atmosphère qui ont permis ces ères glaciaires. Dans un article intitulé De l’influence de l’acide carbonique de l’air sur la température de surface de la Terre, publié en 1896, il relie les évolutions des températures et de la concentration en dioxyde de carbone atmosphérique. Selon lui, un doublement en CO2 conduirait à une augmentation de la température moyenne de la Terre de 4 à 5 °C. Tout comme son collègue et ami Nils Eckholm, il appelait de ses vœux une telle évolution, pensant qu’une augmentation de température serait bénéfique pour tous, particulièrement pour l’agriculture. Mais il pensait qu’il faudrait attendre 3 000 ans avant que cela ne se produise. En 1906, il prétendra même qu’une telle concentration en CO2 pourrait retarder et atténuer la prochaine période glaciaire. Il réitère sa présentation d’un monde plus chaud favorable au bien-être des Hommes, ce qui amène quelque peu l’attention sur sa théorie, pour un temps seulement car elle va ensuite retomber dans l’oubli pendant quelques décennies.

La théorie astronomique des variations climatiques du passé n’a guère plus de succès. Selon elle, les variations que connaît la Terre dans sa manière de tourner sur elle-même et autour du Soleil seraient suffisantes pour expliquer les glaciations récemment reconnues. Elle est proposée pour la première fois en 1842 par un mathématicien français, Joseph Alphonse Adhémar. Mais les connaissances de l’époque sont trop lacunaires, les résultats du savant insatisfaisants : la théorie est accueillie plutôt froidement, avec même quelque virulence. Quelques années plus tard, le géologue écossais James Croll l’améliore, grâce à une meilleure connaissance des paramètres orbitaux de la Terre et de leur évolution, mais les variations cycliques de grande ampleur qu’ils imposent au système climatique sont encore trop mal appréhendées pour remporter l’adhésion.

Encore incomplète à l’aube du XXe siècle, la théorie astronomique des climats s’étoffera suffisamment moins de cinquante ans plus tard pour s’affirmer comme l’explication unique des vicissitudes climatiques d’un lointain passé. Quant à l’effet de serre, s’il n’a pu alors s’imposer comme élément d’explication, sa formulation a alors beaucoup progressé.

Chapitre 2 – Un siècle d’évolution thermique et médiatique

[…]

LE RETOUR DE L’EFFET DE SERRE

Guy Stewart Callendar, un ingénieur anglais, par ailleurs météorologue amateur, remet en 1938, à la Royal Meteorological Society (RMS) un article dans lequel il ressuscite la théorie de Svante Arrhenius selon laquelle l’augmentation de la concentration atmosphérique en dioxyde de carbone aurait pour conséquence une augmentation de la température moyenne de la Terre. À cette date, l’augmentation de température est un fait clairement établi, comme nous avons pu le constater. Mais qu’en est-il de la présence du CO2 dans l’atmosphère ? On ne disposait pas à l’époque de données recueillies systématiquement. Il lui fallut donc réunir des données dispersées, collectées par un très grand nombre de scientifiques, sur une durée suffisamment longue pour qu’une éventuelle tendance se dessine. Ce long travail effectué, il fut en mesure de publier une courbe d’évolution de la concentration en CO2, selon laquelle celle-ci aurait augmenté de 6 % entre 1900 et 1936. Ses calculs indiquent qu’un doublement de cette concentration conduirait à un gain de 2 °C en moyenne, mais l’auteur d’ajouter que ce résultat pourrait être sous-estimé. Callendar, comme Arrhenius, n’y voit que du positif. Outre une progression des cultures vers les hautes latitudes, le CO2 favoriserait directement la croissance des plantes grâce à une photosynthèse plus efficace.

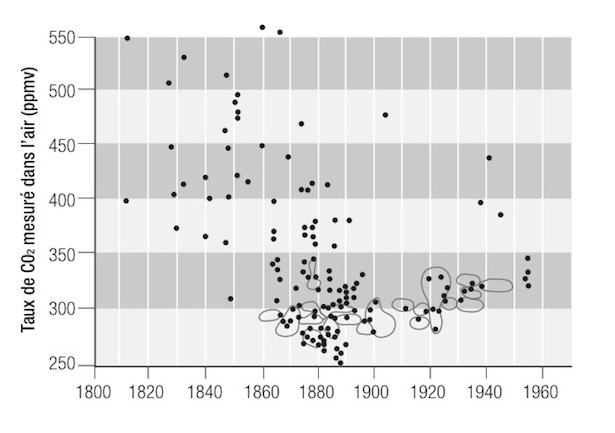

L’article fut discuté à la RMS, où l’on ne peut pas dire qu’il reçut un accueil enthousiaste. George Simpson, qui fut de 1920 à 1938 le directeur du Meteorological Office (dit « Met Office », l’équivalent britannique de la Météorologie nationale en France), voyait dans l’augmentation de température mondiale une fluctuation naturelle du climat, qu’il expliquait par la variation du rayonnement solaire. Selon lui, la concomitance des hausses de température et de la concentration en CO2 n’était qu’une coïncidence. John Henry Coste, de son côté, interrogea Callendar sur la qualité des mesures et la confiance que l’on pouvait leur accorder. Ce dernier répondit que celles qu’il avait utilisées étaient « probablement très précises », raison pour laquelle il les avait retenues. Les publications qui suivirent finirent par éveiller l’intérêt de certains scientifiques. Mais le doute subsista suffisamment pour que d’autres scientifiques se penchent avec attention sur son travail. En 1955, l’américain Giles Slocum publia un article dans la Monthly Weather Review, dans lequel, sans rejeter nécessairement la conclusion de Callendar selon laquelle la concentration en CO2 atmosphérique augmente, il s’interroge sur la méthode de sélection des données retenues, qui l’a conduit à systématiquement mettre de côté les valeurs anciennes trop élevées et les données récentes trop basses. L’année suivante, Stig Fonselius, Folke Koroleff et Karl-Erik Wärme se penchent à leur tour sur les choix opérés par Callendar. Pour cela, ils compilent l’ensemble des données que celui-ci avait alors à sa disposition et réalisent un graphique sur lequel elles sont placées en fonction des années de recueil et de la concentration en CO2 mesurée. Celles qui ont été retenues par Callendar pour la construction de sa courbe sont entourées. La figure d’origine étant peu lisible, voici celle réalisée par Zbigniew Jaworowski dans un article critique :

Comme on le voit, les mesures du XIXe siècle étaient bien souvent supérieures aux valeurs retenues et mises en avant. Nous aurons l’occasion de revenir sur cette question des concentrations en CO2 et de la valeur des mesures, y compris modernes. Le fait est que Callendar, pour étayer sa thèse d’une origine anthropique de la hausse de la teneur atmosphérique en gaz carbonique, elle-même responsable de la hausse de température, a soigneusement choisi ses données, écartant toutes celles invalidant la conclusion à laquelle il souhaitait parvenir.

Malgré cela, l’intérêt grandit pour les émissions de CO2 et leur effet sur la température de l’atmosphère. À la fin des années 1950 commence la campagne de mesure actuellement la plus longue de la concentration en dioxyde de carbone, à Hawaï (voir chapitre 10). L’important développement économique et industriel qui s’étend de l’après-guerre au choc pétrolier de 1973 (les Trente Glorieuses), fortement consommateur d’énergies fossiles et donc grand émetteur de CO2, n’y est sans doute pas pour rien. Pourtant, l’actualité médiatique va de nouveau prendre une autre orientation.

[…]

Chapitre 10 – Et les gaz à effet de serre ?

La question de la responsabilité des gaz à effet de serre dans le réchauffement doit être posée. Comme nous l’avons vu, l’évolution récente du climat n’est pas sans précédent et pourrait donc s’inscrire aisément dans le cadre de ses variations naturelles. Mais le caractère plausible de cette hypothèse ne suffit pas à la rendre avéré. Il est donc nécessaire de se demander si les rejets anthropiques de dioxyde de carbone ne sont pas à l’origine des quelques dixièmes de degrés Celsius caractérisant la hausse reconstituée de la température moyenne globale de la Terre depuis un siècle et demi, même si cette valeur est quelque peu incertaine. La concomitance du réchauffement et des rejets de CO2 depuis la révolution industrielle conduit à envisager cette possibilité Mais là encore, cette hypothèse ne peut être tenue pour avérée simplement parce qu’elle est plausible a priori.

L’HOMME EST-IL RESPONSABLE DE LA HAUSSE DE CONCENTRATION ATMOSPHÉRIQUE EN CO2 ?

Avant même d’explorer l’hypothèse selon laquelle le léger réchauffement qu’a connu la Terre depuis environ 150 ans serait la conséquence de la hausse de concentration atmosphérique en CO2, il convient de s’interroger sur le rôle des activités humaines dans les changements de la composition gazeuse de l’atmosphère observés. La question peut sembler saugrenue, puisque, bien souvent, les climatosceptiques eux-mêmes ne remettent nullement en cause la responsabilité humaine sur ce point.

LA MESURE DU TAUX DE CO2 ATMOSPHÉRIQUE

Depuis la fin des années 1950, à l’initiative de l’Américain Charles D. Keeling, le taux de CO2 atmosphérique est mesuré depuis un laboratoire localisé sur les flancs du volcan Mauna Loa (en activité), dans l’archipel hawaïen, en plein océan Pacifique. La concentration a évolué d’environ 315 à 390 ppmv bientôt. Le choix d’un tel site de mesure est curieux, car s’il est effectivement loin des sources industrielles du CO2 anthropique afin de ne pas être influencé par elles, il est au plus près de celles du volcanisme, ce qui n’est pas sans poser problème et nécessite des corrections en fonction des émissions locales et des vents. D’autres centres de mesure ont été créés de par le monde, sous la direction de la NOAA, dont les donnés sont mises à contribution afin d’avoir une vision globale du CO2 atmosphérique. Mais les sites d’échantillonnage restent assez rares, les séries temporelles sont parfois lacunaires, si bien que les valeurs présentées ne sont pas des données réelles, même si elles en sont issues. De savants calculs en font une information globale, mais caractérisée par une incertitude non négligeable. Il n’en demeure pas moins que l’atmosphère est indéniablement de plus en plus riche en carbone.

UN BILAN INCERTAIN

Les émissions anthropiques de CO2 sont montrées du doigt, car depuis la révolution industrielle elles n’ont cessé d’augmenter, injectant dans le cycle naturel du carbone une contribution anthropique de plus en plus élevée, désormais de l’ordre de 8 milliards de tonnes de carbone (8 GtC) par an. Cette quantité représente un flux supplémentaire dans le bilan annuel du carbone.

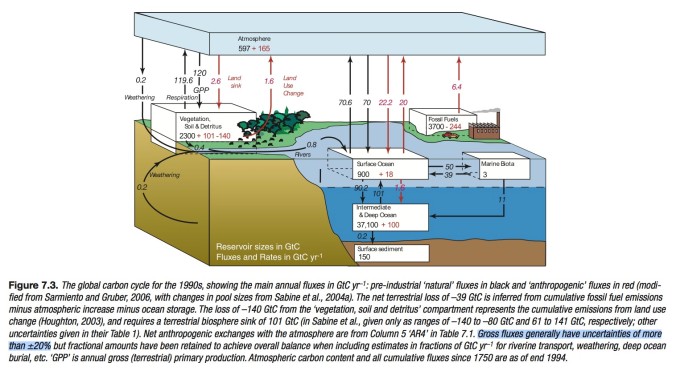

D’après les données fournies par le chapitre 7 du dernier rapport du GIEC, les principaux réservoirs de carbone sont l’atmosphère (760 GtC), la surface des océans (920 GtC), les sols et la végétation terrestre (2260 GtC) ainsi que l’océan intermédiaire et profond (37 200 GtC). Ces différents stocks échangent naturellement entre eux des quantités de carbone dont le total, si on se limite à celles qui concernent l’atmosphère, est presque cinquante fois plus important que les émissions humaines. Ce sont précisément ces flux qui nous intéressent. Toujours d’après ce même rapport, ce bilan naturel serait équilibré (nul), avec une captation du carbone atmosphérique par les sols (0,2 GtC/an), par la photosynthèse des plantes (120 GtC) et les océans (70 GtC), et avec un rejet vers l’atmosphère venant de la respiration (119,6 GtC) et des océans (70,6 GtC). Le bilan anthropique serait lui en déséquilibre, puisque les différents flux (représentant des quantités nettement moins importantes de carbone) ne s’annulent pas. Ainsi, on sait que, chaque année, l’atmosphère reçoit 6,4 GtC (valeur moyenne des années 1990, utilisée par le GIEC) d’origine anthropique mais on n’y en retrouve que la moitié, soit 3,2 GtC, la moitié manquante ayant été retirée par le cycle naturel en même temps que tous les autres flux sortants nettement plus importants qu’il régule. À ce stade, il semble légitime de se demander si la petite contribution anthropique peut ou non déséquilibrer le bilan global et être responsable de la présence croissante de carbone dans l’atmosphère sous forme de CO2. Le GIEC précise, uniquement dans la légende de la figure présentant tous ces flux, qu’ils sont entachés d’une marge d’erreur de plus ou moins 20 %, ce qui est considérable. Les chiffres présentés à la virgule près sont donc en réalité très approximatifs et ajustés de telle sorte que le bilan naturel soit parfaitement équilibré. Par ailleurs, compte tenu d’une part de l’importance des flux de carbone et de notre incapacité à les estimer finement et, d’autre part, de la contribution anthropique comparativement faible, on est en droit de se demander si cette hausse du stock atmosphérique de carbone est réellement liée aux activités humaines. Cette hypothèse peut être testée, grâce à l’estimation des différents flux et de l’incertitude qui leur est attachée. Curieusement, à notre connaissance, ce test, dont le résultat conditionne la pertinence de toutes les études portant sur l’éventuelle implication de l’Homme dans le changement climatique, n’a, jusqu’à présent, jamais été fait sur ces données, ou tout au moins jamais rendu public. Cela est d’autant plus étonnant qu’il est une pratique courante de la recherche. Il permet en effet aux scientifiques d’évaluer les chances qu’ils ont de se tromper en concluant à la validité de leur hypothèse. Le calcul conduit ici à un risque d’erreur de 47 %, si bien qu’il y aurait presque une chance sur deux de se tromper en affirmant que c’est la contribution humaine qui est responsable du déséquilibre positif du bilan annuel de carbone atmosphérique. On est très loin des traditionnels 5 % que ne s’autorisent pas à dépasser les scientifiques dans leurs conclusions. Cela n’invalide pas en soi l’hypothèse de la responsabilité humaine, mais montre que, même si elle était réelle, elle ne pourrait pas du tout être mise en évidence. Ce qui est pourtant affirmé sans la moindre hésitation depuis la création du GIEC en 1988.

QU’EN EST-IL DES DIFFÉRENTES SORTES DE CARBONE ?

L’un des arguments des « carbocentristes » consiste À mettre en avant la composition isotopique du carbone de l’atmosphère. Il existe plusieurs types d’atome de carbone, différenciés par leur masse : les isotopes 12, 13 et 14, que l’on note 12C, 13C et 14C. Le 12C est de très loin le plus commun. D’après l’analyse des bulles de gaz contenues dans les carottages glaciaires en Antarctique, la proportion de 12C et 13C est restée stable avant

L’ACIDIFICATION DES OCÉANS

Le dioxyde de carbone émis par les activités humaines ne se retrouve que pour moitié dans l’atmosphère. Le reste serait absorbé par les océans où il se transformerait en acide carbonique. Certains chercheurs, comme Claude Allègre, affirment donc que l’océan s’acidifierait à cause des rejets anthropiques de CO2. Avec un pH moyen d’environ 8,2, l’eau de mer est considérée comme basique. Avant de s’acidifier elle devient d’abord moins basique. Les quantités de CO2 nécessaires pour rendre les eaux de surface des océans acides (pH inférieur à 7) seraient considérables, et les énergies fossiles disponibles sans doute insuffisantes pour y parvenir. Une étude a établi qu’entre 1751 et 2004, le pH des eaux océaniques superficielles était passé de 8,25 à 8,14. Ce résultat sous-entend que nous sommes capables de détecter au niveau mondial une variation de pH de 0,1, alors même que les mesures disponibles sont parcellaires et très récentes. De telles reconstitutions sont terriblement approximatives et servent à annoncer par extrapolation qu’en 2100, le pH sera d’environ 7,85. Pourtant il ne suffit pas de savoir combien de CO2 est rejeté pour connaître la part qui demeure dans l’atmosphère et celle qui va se dissoudre dans l’océan et l’acidifier. La Vie s’en mêle et agit en sens contraire, d’une manière qu’il est actuellement impossible de quantifier. Une plus forte concentration atmosphérique en CO2 favorise en effet la photosynthèse et donc la croissance végétale, si bien que la végétation terrestre stocke plus de carbone. De même, une plus forte dissolution de carbone dans l’eau de mer semble bénéfique à un certain nombre d’espèces marines, qui en stockent plus dans leur carapace ou leur coquille, tandis que d’autres semblent indifférentes, comme les coraux testés par l’Institut océanographique Woods Hole (États-Unis). Les dangers qui menacent les océans sont donc certainement ailleurs.

les rejets massifs des industries modernes. À partir de la révolution industrielle, ce rapport aurait été peu à peu modifié, car le carbone issu de la combustion des énergies fossiles est plus riche en 12C. C’est ce type d’analyse qui permet de dire que seule la moitié du CO2 émis par les activités humaines est retrouvée dans l’atmosphère. Les analyses isotopiques révèleraient par ailleurs, aux yeux de certains scientifiques, que la hausse de concentration en CO2 atmosphérique est la conséquence des émissions anthropiques. Elles ne révèlent cependant qu’une chose : du charbon et du pétrole (principalement) ont été abondamment brûlés. La base de la théorie de l’effet de serre dû à l’Homme n’en est pas plus consolidée.

Les isotopes du carbone permettent cependant d’explorer une voie quelque peu différente. Les essais nucléaires réalisés dans l’atmosphère durant les années 1950 et 1960 ont conduit à une importante formation de carbone 14. Le suivi des concentrations en carbone 14 a permis de constater qu’il fallait plusieurs années avant qu’il ne soit uniformément réparti dans les deux hémisphères, entre lesquels les échanges sont très lents. Or, l’essentiel du CO2 anthropique est émis dans l’hémisphère nord, sans que ne soit constaté un quelconque décalage temporel de sa concentration dans l’hémisphère sud. Cette absence de décalage temporel plaide pour une origine essentiellement naturelle de la hausse du CO2. Des événements climatiques similaires ont eu lieu par le passé, comme nous l’avons vu, tout au long de l’Holocène. Les données glaciaires amènent pourtant à penser que le taux de CO2 a été d’une remarquable stabilité durant des milliers d’années, ce qui est en contradiction avec la possibilité d’une récente augmentation naturelle, conséquence et non cause du réchauffement. Mais les glaces sont-elles une source fiable d’information ?

LES CAROTTAGES GLACIAIRES NOUS RACONTENT-ILS UNE FABLE?

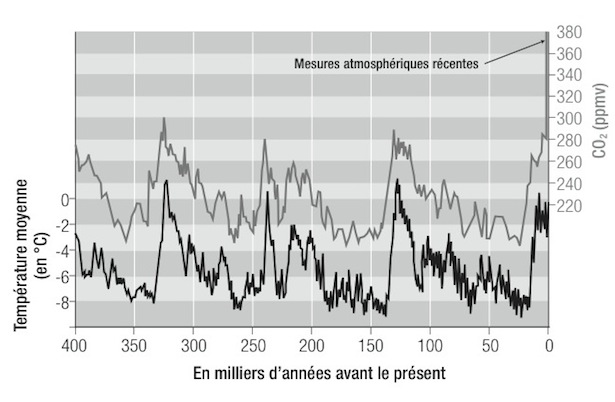

L’année géophysique internationale de 1957 a marqué la naissance de la glaciologie polaire, particulièrement celle de l’Antarctique. Les pionniers ont d’abord fait œuvre d’explorateurs plus que de scientifiques, mais très vite l’étude des isotopes de la glace extraite par forage permet de connaître la température régnant lors de sa formation. La glace étant de plus en plus ancienne à mesure que l’on fore profondément, il est possible de reconstituer l’évolution thermique du continent austral. En 1965, alors qu’il venait de plonger dans son whisky un glaçon fraîchement remonté d’un forage à 100 mètres de profondeur, le glaciologue français Claude Lorius est interpellé par la libération des bulles d’air que le glaçon conservait depuis sa formation. Leur analyse ne pourrait-elle pas renseigner sur la composition de l’atmosphère de l’époque ? Cette idée astucieuse trouvera son meilleur terrain d’expérimentation dans les forages que les Soviétiques avaient entrepris, seuls d’abord, dans leur base isolée de Vostok, à 3844 mètres d’altitude, en n’ayant toutefois pas les moyens techniques d’en retirer toutes les informations disponibles. Cette collaboration débouchera en 1987 sur la publication dans la revue Nature des résultats de ces analyses : l’évolution des températures et celle de la concentration atmosphérique en CO2, très bien corrélées sur plusieurs centaines de milliers d’années.

On y voit clairement l’alternance des glaciations et des périodes interglaciaires. Le comportement de la courbe du CO2 y est très proche de celle de la température. Ce n’est cependant pas une confirmation de ce qu’envisageaient certains scientifiques de la deuxième moitié du XIXe siècle : le pilotage des glaciations par les variations du dioxyde de carbone. On sait désormais que ce sont les variations des paramètres orbitaux de la Terre qui en sont le moteur. Tout au plus affirme-t-on désormais, pour maintenir le CO2 dans la course, qu’il accompagne la sortie des ères glaciaires, en jouant un rôle non de déclencheur, mais d’amplificateur, ce qui est cohérent avec son statut de gaz à effet de serre. Les techniques d’analyse récentes ont d’ailleurs permis de mettre en évidence ce qui n’apparaissait pas auparavant : les changements de concentration atmosphérique en CO2 ne surviennent que plusieurs centaines à plusieurs milliers d’années après les variations de température. On considère qu’en la matière ce sont les échanges entre les océans et l’atmosphère qui sont la clef de ce décalage. Un océan froid est un puits de carbone que l’atmosphère lui cède. Inversement, un océan suffisamment réchauffé rejette plus de CO2 qu’il n’en absorbe. S’appuyer sur ces résultats pour expliquer l’impact potentiel du CO2 sur le système climatique, comme l’a fait Al Gore dans son film, n’est rien d’autre que mensonger. Les fluctuations du CO2 depuis 400 000 ans et plus ne sont qu’une conséquence des changements climatiques. D’après ces données glaciaires, la concentration en dioxyde de carbone aurait été stable depuis le début de l’Holocène jusqu’au XVIIIe siècle, soit pendant des milliers d’années, à une valeur d’environ 280 ppmv (0,028 % d’un volume d’air). La modification anthropique apparaît clairement, comme un événement sans précédent depuis au moins des centaines de milliers d’années. La concomitance entre la révolution industrielle et cette hausse de concentration atmosphérique n’est pas suffisante pour affirmer la responsabilité humaine, mais les valeurs atteintes semblent un argument fort.

Ce scénario scientifique repose sur un postulat implicite, qui explique peut-être cette interrogation de Claude Lorius : « Étonnamment, personne n’a contesté le fait que l’on puisse représenter l’atmosphère de la planète en faisant un simple trou dans les glaces de l’Antarctique… » Peut-être ne voulait-il parler que de la représentativité spatiale des mesures, qui concerne une petite partie du globe, et que l’on étend rapidement à son ensemble. Mais prétendre étudier l’évolution du CO2 atmosphérique à partir des bulles prisonnières de la glace ancienne suppose aussi que l’on s’est assuré sur le plan théorique que l’air qu’elles renferment est bien de la même composition que l’atmosphère de l’époque à laquelle elles se sont formées. Autrement dit, il ne faut pas que cet air se soit altéré, au moment de leur enfermement et depuis lors. La remise en question de ce présupposé est venue du Polonais Zbigniew Jaworowski. Président du conseil scientifique du Laboratoire Central de Radioprotection de Varsovie et ancien président du Comité scientifique des Nations unies sur les effets des radiations atomiques, cet éminent physicien a été responsable de projets de recherche pour l’Agence américaine de protection de l’environnement et pour l’Agence internationale de l’énergie atomique. Ce spécialiste des pollutions atmosphériques est également devenu un fin connaisseur des carottages glaciaires, qu’il a pratiqué sur les hautes montagnes de tous les continents et aux pôles, à la recherche notamment des disséminations radioactives dues aux essais nucléaires et aux accidents de réacteurs de centrales atomiques. C’est en constatant que les contaminants qu’il étudiait migraient au sein même de la glace que Jaworowski en est venu à remettre en cause la valeur de représentativité des proportions respectives des différents gaz contenus dans les bulles d’air qui en sont prisonnières. Même à des températures extrêmement basses, la présence d’eau liquide dans la glace est commune. Or, dans l’eau froide, le CO2 est 70 fois plus soluble que l’azote et 30 fois plus que l’oxygène, si bien que l’air emprisonné dans la glace environnante va changer de composition. La pression jouerait aussi un rôle important. Les données du terrain illustrent bien ces nombreux biais. Dans les forages des stations antarctiques Byrd et Vostok, où les vitesses respectives d’accumulation de la glace sont différentes, on observe à la profondeur de 500 mètres une forte baisse de concentration en CO2, pour des échantillons ayant 16 000 ans d’écart. Inversement, des glaces d’âge identique présentent des concentrations en CO2 totalement différentes. La reconstitution de l’évolution du CO2 atmosphérique grâce aux glaces polaires apparaît donc comme un artefact. Selon Jaworowski, qui a passé en revue un grand nombre de publications, les données jugées incohérentes car différant du résultat attendu, sont écartées, sans autre forme de procès. Ce serait jusqu’à 20, 30 voire parfois 40 % des données qui ne seraient pas retenues. Dans ces conditions, il est en effet permis d’affirmer que jamais le taux de CO2 n’a été aussi élevé. En 1994, lorsqu’il proposa, avec ses collègues de l’Institut polaire norvégien, pour lequel il travaillait alors, un projet de recherche sur la fiabilité des études basées sur les carottes de glace, on lui répondit que l’allocation de fonds lui était refusée parce qu’une telle entreprise serait « immorale » si elle servait à saper les bases de la recherche sur le climat.

Les critiques de Jaworowski ne reçurent pas un accueil favorable de la part du monde de la glaciologie, dont le travail aurait vu sa portée considérablement réduite en cas de validation. Elles sont pourtant cohérentes avec les reconstitutions de la concentration atmosphérique en CO2 par l’intermédiaire d’autres indicateurs, comme les stomates de plantes fossilisées. Les stomates sont des ouvertures microscopiques situées sur les feuilles des végétaux, par où ont lieu les échanges gazeux lors de la respiration et de la photosynthèse. Leur étude permet de connaître assez précisément le taux de CO2 atmosphérique lors de la fossilisation, dont l’ancienneté est connue par datation de l’échantillon au carbone 14. Les résultats indiquent des taux parfois conformes aux indications des carottes de glace, mais souvent plus élevés et surtout marqués par d’importantes fluctuations, en concordance avec les variations climatiques.

Pour les concentrations en CO2 plus récentes (mais antérieures aux mesures de Keeling), les 90 000 mesures réalisées par des scientifiques en divers points du globe durant les XIXe et XXe siècles constituent une alternative aux données glaciaires. Sous réserve qu’elles ne soient pas majoritairement non représentatives de l’atmosphère de l’époque, ce qui apparaît peu vraisemblable, elles conduisent à la conclusion que récemment encore le CO2 atmosphérique a connu d’importantes variations de concentration. La reconstitution des températures en Antarctique pour ces deux derniers siècles apparaît d’ailleurs bien mieux corrélée à ces valeurs qu’aux indications glaciaires.

Il ressort donc à ce stade que non seulement la détection d’une possible contribution anthropique à la hausse de concentration atmosphérique en CO2 est impossible, mais encore qu’à toutes les échelles de temps, les variations climatiques ont été accompagnées de fluctuations concomitantes du taux de CO2, parfois à des niveaux proches de celui que nous connaissons actuellement. L’évolution récente du CO2 atmosphérique pourrait donc être, au moins pour partie, naturelle, non pas la cause, mais la conséquence du réchauffement. Ce qui pose la question du rôle du dioxyde de carbone dans l’effet de serre. Là encore, les incertitudes sont telles, qu’affirmer que le très incertain bilan atmosphérique excédentaire de ce gaz est responsable du réchauffement récent de l’atmosphère terrestre est pour le moins délicat.

LE DIFFICILE BILAN RADIATIF DE LA TERRE

Le bilan radiatif de la Terre représente le solde du rayonnement reçu par notre planète en provenance du Soleil et du rayonnement réémis par celle-ci en direction de l’espace. Malgré quelques menues fluctuations, on considère que la quantité d’énergie en provenance du Soleil est d’une grande stabilité, ce pourquoi on l’appelle « constante solaire ». Elle est mesurée au sommet de l’atmosphère et représente environ 1367 W/m2 (watts par mètre carré). Cette valeur théorique n’est valable que pour un disque perpendiculaire au rayonnement solaire. Une sphère ayant une superficie quatre fois supérieure à celle d’un disque de même rayon, il faut donc diviser par quatre la constante solaire pour connaître la quantité moyenne de rayonnement solaire arrivant sur Terre : 342 W/m2. Les nuages, l’atmosphère et la surface de la Terre réfléchissent ou diffusent une partie de ce rayonnement vers l’espace et en absorbent une autre. Ils émettent à leur tour un rayonnement, dont les caractéristiques sont différentes. Compte tenu de sa température, la Terre émet dans l’infrarouge, une longueur d’onde que les gaz dits à effet de serre (la vapeur d’eau, le dioxyde de carbone, le méthane et le protoxyde d’azote) absorbent, alors qu’ils sont plutôt transparents au rayonnement solaire. Selon la théorie de l’effet de serre, ils réémettent à leur tour un rayonnement en direction de la surface de la Terre (backradiation), qu’ils réchauffent. L’équilibre thermique de la planète est conditionné par un bilan radiatif nul. Qu’il devienne positif et la Terre se réchauffe. Ce à quoi devrait logiquement conduire une quantité croissante de gaz à effet de serre dans l’atmosphère. Le quatrième rapport du GIEC évalue l’effet de cette hausse de concentration des gaz à effet de serre, au premier rang desquels le CO2, à 1,6 W/m2. L’estimation de ce forçage radiatif (attribué d’autorité à l’Homme) est cependant caractérisée par une marge d’erreur importante, puisque la fourchette va de 0,6 à 2,4 W/m2, due aux nombreuses inconnues. Le « niveau de compréhension scientifique » de nombreuses composantes du forçage radiatif est considéré comme faible par le GIEC. Une remarque confirmée par la consultation de plusieurs bilans radiatifs, y compris lorsque les auteurs sont les mêmes. L’américain Kevin Trenberth, auteur principal pour les deux derniers rapports d’évaluation du GIEC, a publié à quelques années d’intervalle deux bilans radiatifs sensiblement différents. Le premier est curieusement en équilibre (la Terre ne se réchauffe pas) et, de manière cocasse, utilisé par le GIEC dans son dernier rapport, tandis que le second est caractérisé par un excédent de 0,9 W/m2, marque du réchauffement. Ce n’est pas là la seule différence. Les flux du bilan radiatif de la Terre varient entre ces deux exemples de plusieurs W/m2, jusqu’à une dizaine. L’incertitude est donc là aussi très grande et rend délicate la caractérisation d’un forçage qui lui est bien inférieur. Elle est cependant reconnue dans ces articles, les auteurs précisant que l’estimation des flux est raisonnable, mais pas exacte.

Une augmentation de la concentration de ces gaz à effet de serre doit théoriquement conduire le système climatique à se caler sur un équilibre différent, induisant une hausse de température. Si la présence des gaz à effet de serre ne cesse de croître, la température devrait elle aussi constamment augmenter. En théorie. Le refroidissement d’après-guerre semble en contradiction avec un effet de serre qui aurait dû être de plus en plus important. La forte croissance économique de cette époque (les Trente Glorieuses) a en effet été synonyme d’importants rejets de CO2. Cet épisode, qui a fait craindre à certains le retour d’un Petit Âge de glace, était expliqué par les fines particules (aérosols) rejetées par l’industrie dans l’atmosphère, dont l’effet refroidissant était jugé supérieur à l’effet réchauffant du CO2. Les modèles utilisés pour prévoir l’avenir climatique de la planète d’ici quelques décennies peuvent également être utilisés pour reconstituer le passé. Mais en l’absence de toute mesure de ces aérosols, cette variable était simplement ajustée de manière à faire coller chaque modèle aux observations de l’époque. Puis des chercheurs en sont venus à douter tout simplement de ce refroidissement. Les océans représentant près de 71 % de la superficie de la Terre, la connaissance de leur température est importante dans la détermination de celle du globe tout entier. Faisant valoir l’existence d’un changement dans la manière de procéder aux mesures de température de surface des océans après la Seconde Guerre mondiale, ayant conduit selon eux à une importante sous-estimation, ils en ont conclu que ce que l’on prenait jusqu’alors pour un refroidissement n’avait été qu’une simple pause. Cela est contraire à ce que l’on sait de l’évolution du climat sur les continents, mais a pour avantage de présenter un scénario moins embarrassant pour le rôle central des gaz à effet de serre. En revanche, il l’est beaucoup plus pour les modèles qui, comme l’a fait malicieusement remarquer Richard Lindzen, ont donc « correctement simulé des donnés incorrectes ».

RECHERCHE CHALEUR DÉSESPÉRÉMENT

La température des océans est désormais connue de manière beaucoup plus fiable, grâce à un excellent réseau de 3000 balises semi-immergées. Par rapport aux mesures antérieures, elles donnent une température légèrement supérieure, car mesurée dans une couche d’eau plus chaude (pas juste sous la surface). La mise en place progressive de ce réseau s’est étendue de 1977 à 2003, période pendant laquelle la place de ces mesures dans le calcul de la température des océans a ainsi été croissante. La hausse constatée de cette variable pourrait donc s’expliquer au moins partiellement de la sorte. Le réchauffement de la surface des océans est néanmoins un fait semblant clairement établi sur la période 1993-2008. À partir de 2003, la mise en place du réseau de balises étant terminée, il a été possible d’exploiter pleinement les données fournies, qui nous renseignent sur la température de la couche supérieure de l’océan, jusqu’à 700 mètres de profondeur. Contrairement à l’océan intermédiaire et profond, dont l’inertie thermique est importante, cette couche d’eau supérieure est sensible à court terme aux fluctuations climatiques. Compte tenu de l’extension des océans, mais aussi du fait que cette mesure de température n’est pas soumise aux biais rencontrés sur les continents, beaucoup de spécialistes de ces questions, comme Roger Pielke Sr., climatologue à l’université de Boulder (Colorado), considèrent que le suivi du contenu thermique des océans représente la meilleure approche possible de l’évolution de la température moyenne globale. Or, depuis 2003, il apparaît que les océans ne se réchauffent plus, voire qu’une légère tendance à la baisse se dessine. L’article de 2006 qui a mis en évidence cette découverte a jeté le trouble, car les modèles sont unanimes : le réchauffement ne peut que se poursuivre. La stagnation de la température globale des basses couches de l’atmosphère reconstituée par le Hadley Centre–CRU de Phil Jones, ou le fort ralentissement de la hausse constaté par le GISS de James Hansen étaient déjà en contradiction avec les modèles, mais il était mis en avant que, la chaleur ne pouvant avoir disparu, elle se situait très probablement dans les océans. Une critique de l’article a mis en évidence une série de biais, au grand soulagement des alarmistes du réchauffement climatique. Mais les corrections faites par les scientifiques ont confirmé leur première conclusion. Cette mise à jour de leur article, d’ailleurs validée par des analyses indépendantes, passe généralement inaperçue auprès des journalistes, qui croient ainsi pouvoir continuer à prétendre que l’évolution récente du climat est conforme aux prévisions des modèles et du GIEC. Pour les scientifiques, au contraire, il y a là un élément d’interrogation de premier plan.

Dans l’un des courriels du Climategate, Kevin Trenberth fait part à Michael Mann de son embarras : « Le fait est que nous ne pouvons expliquer l’absence actuelle de réchauffement, ce qui est grotesque ». Il a récemment publié dans Nature un court article, sous-titré « Où est passée l’énergie du réchauffement global ? ». Trenberth constate que les observations divergent de plus en plus de la théorie de l’effet de serre anthropique, tant du point de vue du flux radiatif s’échappant vers l’espace (limitant le réchauffement), bien plus important qu’attendu par les modèles, que de la chaleur manquante, qu’il pensait être dans les océans. Son point de vue est ambivalent. Dans un autre courriel, il explique que l’on est encore loin de pouvoir établir le bilan énergétique de la Terre, dont il est un spécialiste mondial, notamment auprès du GIEC. Cependant, il considère également, aussi bien dans les courriels que publiquement, que si cette chaleur manquante n’est pas retrouvée, c’est que le système de balises argo est inadapté à sa détection et que si la manière d’envisager le bilan radiatif n’est pas validée par les observations, c’est que les outils pour les recueillir sont déficients. Une foi dans les modèles désarmante. D’autres chercheurs, comme Robert Knox et David Douglass, du département de physique et astronomie de l’université de Rochester (États-Unis), confirment le refroidissement des océans, nient l’existence d’une « chaleur manquante » et affirment que Trenberth et ses collègues surestiment fortement le déséquilibre radiatif. Les modèles sont unanimes, mais les modèles se trompent.

ON A PERDU LA TRACE DE L’EFFET DE SERRE

D’après les modèles, la hausse de concentration des gaz à effet de serre devrait se traduire par un réchauffement de l’atmosphère inégal selon la latitude et l’altitude. C’est au-dessus des régions intertropicales, vers 10 kilomètres d’altitude, qu’il doit être le plus marqué, ce que l’on a appelé le hot spot, le « point chaud ». Les seules différences entre modèles concernent l’intensité de ce réchauffement, mais pour tous, il doit y être supérieur à celui de toutes les autres régions de l’atmosphère. Le GIEC fait bien sûr mention de cette signature théorique de l’effet de serre additionnel dans son dernier rapport d’évaluation. En revanche, les résultats de la confrontation avec le réel sont totalement tus. Les mesures de température des différentes couches de l’atmosphère, par ballon sonde et par satellites, montrent sans ambiguïté l’absence de ce point chaud. Non seulement le réchauffement de l’atmosphère n’a pas été plus rapide en altitude au-dessus des tropiques, mais c’est de plus précisément l’inverse : la troposphère (l’atmosphère jusqu’à 15 km d’altitude aux basses latitudes, 10 km dans la zone tempérée) s’est globalement moins réchauffée que la surface de la Terre : jusqu’à 5 kilomètres d’altitude, c’est un réchauffement de moins en moins important qui est observé.

Pour prédire le réchauffement catastrophique à venir, le GIEC utilise des modèles qui non seulement livrent une image erronée des évolutions actuelles, ce qui montre notre faible compréhension du phénomène de l’effet de serre, mais aussi surestiment le réchauffement d’un facteur 2 à 3. Le GIEC attribue au CO2 une capacité à augmenter la température moyenne globale de 3 °C pour un doublement de sa concentration. De nombreux chercheurs parviennent à des valeurs nettement inférieures, de l’ordre d’un degré Celsius, voire moins d’un demi : Roy Spencer, Richard Lindzen, Syun-Ichi Akasofu, déjà rencontrés dans ces pages, mais aussi William Gray, professeur émérite à l’université d’État du Colorado (États-Unis), Stephen Schwartz, du Brookhaven National Laboratory (États-Unis), ou encore Oleg Sorochtin, spécialiste du climat à l’Institut d’océanographie de l’Académie des sciences russe, qui a déclaré que « même si la concentration en gaz à effet de serre doublait, l’Homme n’en percevrait pas l’impact sur les températures ».

L’EFFET DE SERRE EST-IL BIEN CELUI QUE L’ON CROIT ?

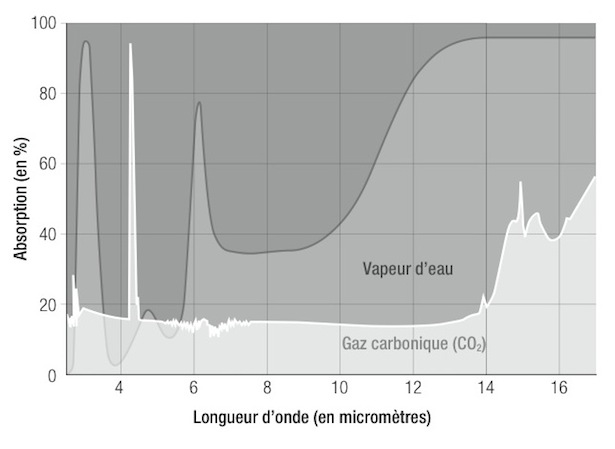

Se pourrait-il que le dioxyde de carbone soit d’un effet si marginal sur le système climatique de la Terre que le doublement de sa concentration ne conduise qu’à une hausse de température insignifiante ? Il est souvent mis en avant que les émissions de CO2 peuvent mener à une situation analogue, dans son principe sinon dans son intensité (la « poêle à frire » de Michel Rocard), à la situation prévalant sur la planète Vénus. L’atmosphère de cette dernière est très largement composée de CO2 (96,5 % contre 0,039 % sur Terre) et l’effet de serre y est très important, ce qui en fait la planète la plus chaude du système solaire : environ 460 °C en moyenne. James Hansen a été un spécialiste de l’atmosphère vénusienne avant de se consacrer à celle de la Terre. Le journaliste Fabrice Nicolino explique ainsi l’influence que ces premières recherches ont eu sur son travail postérieur : « Et si cette planète, en des temps infiniment anciens, avait été accueillante pour la vie ? Et si un effet de serre cataclysmique, fondé sur une accumulation de gaz carbonique, avait changé la planète entière en un désert définitif ? » Pour James Hansen, nos rejets de CO2 peuvent mettre en route un scénario similaire. Depuis, l’idée d’une planète Vénus primitivement favorable aux conditions de la vie n’a pas été rejetée, mais le mécanisme qui aurait conduit au terrible effet de serre actuel, n’est plus le même : c’est l’évaporation des eaux de surface qui aurait conduit à un effet de serre accru. Le CO2 n’aurait pas participé à cette évolution du climat vénusien, pas plus qu’il ne jouerait un rôle dans l’effet de serre actuel de cette atmosphère. Voici comment l’Institut de mécanique céleste explique l’effet de serre sur Vénus : « Cette température est la conséquence d’un effet de serre résultant non du dioxyde de carbone (CO2) mais de constituants en très faibles quantités relatives tels que [le dioxyde de soufre] SO2 et [la vapeur d’eau] H2O. En effet, dans le domaine infrarouge correspondant au maximum d’émission thermique pour un corps à la température de la surface et de la basse atmosphère de Vénus, le CO2 présente des fenêtres de transmission très larges qui ne peuvent piéger efficacement le rayonnement infrarouge. En revanche, SO2 et H2O, bien qu’en très faibles quantités, absorbent les radiations dans ce domaine de longueurs d’onde ». Les différents gaz à effet de serre absorbent le rayonnement infrarouge qu’émettent Vénus et la Terre, mais ils sont tous plus ou moins efficaces selon la longueur d’onde de ce rayonnement et ce, de manière spécifique. La figure suivante, réalisée à l’aide de deux documents de l’École normale supérieure de Lyon, montre l’absorption du CO2 et de la vapeur d’eau en fonction de la longueur d’onde du rayonnement.

Comme on le voit, le CO2 présente un pic d’absorption pour un rayonnement de longueur d’onde d’environ 4 micromètres, mais sur tout le reste du spectre la vapeur d’eau est beaucoup plus efficace. Ainsi, bien qu’en infime quantité dans l’atmosphère vénusienne (0,002 %), c’est elle qui, avec le dioxyde de soufre (0,015 %), y est responsable de l’effet de serre.

Sur Terre, la vapeur d’eau, bien qu’inégalement répartie dans l’atmosphère, y est en quantité très supérieure au CO2. Cette concentration plus grande et une capacité d’absorption du rayonnement infrarouge plus efficace en font sur Terre aussi le principal gaz à effet de serre. Ce sont précisément de tels arguments qui, durant plus de la moitié du XXe siècle, ont conduit nombre de scientifiques à rejeter la thèse de Svante August Arrhenius et, à partir des années 1930, de Guy Stewart Callendar (voir chapitres 1 et 2), selon laquelle le CO2 serait un élément de premier plan de l’évolution du climat. D’Anders Jonas Ångström, qui publia le premier spectre d’absorption du CO2 au début du XXe siècle, à Hans Panovsky dans les années 1950, représentatif de la majorité des météorologues de l’époque, il était souvent considéré qu’une augmentation de la concentration atmosphérique en CO2 ne serait que d’un effet minime. Nombre de scientifiques climatosceptiques estiment actuellement que la vapeur d’eau représente à elle seule 95 % de l’effet de serre terrestre. Pour le GIEC et les scientifiques de l’alarmisme climatique, la vapeur d’eau rentre pour environ 60 % de l’effet de serre terrestre et le CO2 35 %. Dans ces conditions, une augmentation de la concentration de celui-ci ne peut être sans effet. Mais le physicien de l’atmosphère Ferenc Miskolczi, spécialiste des transferts radiatifs, fait remarquer que les modèles actuels n’envisagent pas les effets du CO2 en tenant compte simultanément des autres gaz à effet de serre, tel que cela a lieu dans l’atmosphère ; ils calculent d’abord l’augmentation de température induite par plus de CO2, puis en déduisent la présence accrue de vapeur d’eau qui, elle-même, réchauffe l’atmosphère et la surface terrestre et ainsi de suite. Cela ne peut se passer ainsi et les interactions avec les autres gaz à effet de serre agissant simultanément ne peuvent pas ne pas être prises en compte. On a vu l’importance que cela revêt avec la figure de l’absorption de la vapeur d’eau et du CO2 en fonction de la longueur d’onde du rayonnement : l’effet de celui-ci peut être très limité par l’effet de celle-là et les considérer l’un après l’autre ne peut conduire qu’à des erreurs. D’autant plus que, toujours selon Miskolczi, cette hausse de température due à plus de CO2 doit s’accompagner d’une légère diminution de la concentration atmosphérique en vapeur d’eau, ce qui est observé et contrarie donc le réchauffement. Autrement dit, l’effet de serre est constamment saturé et l’emballement climatique totalement impossible.

Les bases sur lesquelles repose le scénario privilégié par le GIEC apparaissent donc bien fragiles. Les modèles de l’effet de serre peinent à reconstituer le passé et ne savent pas décrire l’évolution actuelle. Pourquoi faudrait-il leur accorder du crédit pour leurs prévisions à court et moyen termes ? Les bases physiques elles-mêmes sur lesquelles ils se fondent sont discutées par des scientifiques de haut niveau. Des physiciens, notamment allemands, remettent en cause fondamentalement les bases de la théorie radiative de l’effet de serre, tandis que des scientifiques russes ont développé une approche nouvelle, ne reposant pas sur les échanges radiatifs et donnant d’excellents résultats. Le débat est donc loin d’être clos et les gaz à effet de serre, bien que toujours accusés, pourraient avoir un excellent alibi. Le ou les responsables du réchauffement climatique du XXe siècle, eux, courent toujours…

La suite dans les chapitres 11 et 12, « L’hypothèse solariste », puis « Vers un refroidissement ? »…

Article sans valeur pondu par quelqu’un qui ignore totalement les lois de la physique. Il cite Miskolczi dont la théorie est parfaite contradiction avec la loi de Kirchhoff. il ignore la relation de Clausius/Clapeyron pour ce qui est de la quantité de vapeur d’eau dans l’atmosphère et il ignore également le principe de conservation de masse.

J’arrête là car il me faudrait trois jours pour démonter toutes les erreurs qu’il y a dans ce « papier ».

J’aimeJ’aime

Et voici Robert, troll de son état, qui pose ses crottes avec professionnalisme depuis bien plus de dix ans, partout, dès qu’il le peut, avec une grande constance dans les arguments. Généralement de deux types : « l’auteur est nul, il n’y connaît rien » et « Il y aurait tant à dire qu’on ne peut tout dire et du coup je ne dirai rien ».

J’aimeAimé par 1 personne

A vous de nous prouver que vous avez raison, pour le moment tout ce que vous faites c’est inventer une nouvelle physique (vous n’êtes pas le seul hélas). L’effet de serre et le rôle prépondérant du CO2 dans celui-ci sont parfaitement compris.

Un petit cours ? Cliquez sur enseignement puis sur le PDF Transfert radiatif et effet de serre.

http://www.lmd.ens.fr/legras/

Hors-sujet mais qui m’intéresse, vous vous prétendez géographe alors je voudrais savoir quel était votre sujet de thèse car je n’ai absolument rien trouvé à votre nom.

ps Appeler troll une personne qui vous montre vos erreurs catégorise son auteur et lui enlève définitivement le peu de crédit qu’il aurait pu avoir.

J’aimeJ’aime

Je ne me prétends rien du tout, je n’ai que faire des étiquettes. Si ça n’avait tenu qu’à moi, il n’y aurait pas eu de « bio » en quatrième de couverture, ni même mon nom. Je me fiche bien et on devrait bien se ficher de qui parle. Seul compte ce qui est dit. Par exemple, la licence d’histoire du journaliste Huet n’est pas un problème pour moi, je le lis comme n’importe qui d’autre.

Merci pour le lien, ceux qui ne connaissent pas Legras pourront aller y jeter un oeil. Un peu de subtilité, c’est bien. Fut un temps, où vous inondiez votre propos de liens. Un seul fait moins troll, même si c’est trop tard : on vous connaît.

J’aimeJ’aime

Une vidéo explicative sur ce sujet Arezki ?

J’aimeJ’aime

Merci pour votre étude.

J’aimeJ’aime

J’aime bien votre façon d’esquiver les problèmes. Pas un mot sur la physique de l’effet de serre qui est pourtant un pré-requis quand on prétend en nier l’existence en citant G&T.

« » » » »Des physiciens, notamment allemands, remettent en cause fondamentalement les bases de la théorie radiative de l’effet de serre, « » » »

J’aimeJ’aime

Content que ça vous plaise.

J’aimeJ’aime

Le réchauffement climatique anthropique n’est pas scientifique, pour une simple raison, c’est que cette hypothèse ne répond pas à la condition essentielle définie par Karl Popper. On ne saura si cette hypothèse est vraie que dans le futur. Prévoir le futur est toujours fort complexe. L’hypothèse du GIEC, qui est un organisme politique et non scientifique est une croyance de type religieux. Cela ne veut pas dire qu’elle est fausse, mais qu’elle n’est pas scientifique.

Prévoir avec un degré de certitude suffisant le résultat d’un système aussi complexe que le climat à moyen terme est une gageure. Le nombre de paramètres, de rétro-actions et d’effets « papillon » rend la tâche impossible. D’autant plus que la plupart des mécanismes physiques et chimiques invoqués sont eux-mêmes des hypothèses.

On ferait mieux de dépenser plus dans la recherche scientifique que de pénaliser l’économie des pays européens qui sont quasi les seuls à se préoccuper du problème. Les mesures prises par les pays « réchauffistes » sont largement annihilées par la croissance de pays qui s’en foutent, notamment dans le Sud-Est asiatique. Le seul résultat prévisible sera le déclin économique de l’Europe.

J’aimeAimé par 1 personne

Bonjour,

Moi j’aime bien le livre de Monsieur Arezki, car il élargit le débat en dehors du champ de la physique et le replace dans un contexte qui pourrait appaiser les esprits et permettre aux scientifiques de discuter sereinement.